¡Hola!

He decido empezar este curso de varias maneras, así que es normal que haya cosas que no entiendas mientras lees estas líneas por primera vez, así que no te preocupes, el objetivo de esta lección es sencilla. Es mostrarte como fuimos del punto A al Punto B:

¿Cómo empezó todo esto?

Antes incluso que la primera foto tuvo que pasar muchas, muchas cosas. Los padres de las computadoras son las calculadoras, pero para entender como llegamos a una computadora hay que entender primero la historia de sus padres, las calculadoras.

Calculadora de Antikythera: ¿Viajes en el Tiempo?

La primera calculadora conocida sigue siendo un auténtico misterio. En 1900, submarinistas cazadores de esponjas en Grecia descubrieron cerca de la diminuta isla de Antikythera restos de un antiguo naufragio del primer siglo antes de Cristo.

Entre las estatuas y vasijas rotas se encontraron algunas piezas de bronce corroído, que parecían ser parte de una máquina.

Entre las estatuas y vasijas rotas se encontraron algunas piezas de bronce corroído, que parecían ser parte de una máquina.

Cincuenta años tardaron los estudiosos en descubrir cómo encajaban estas piezas y lograr que el aparato funcionara.

El resultado fue una especie de calculadora astronómica, que funcionaba igual que un ordenador analógico moderno, con piezas mecánicas para hacer los cálculos. Al girar una manivela se accionaban unas palancas; estas, a su vez, accionaban unos cuadrantes con los que se podía leer la posición del Sol y los planetas del zodiaco.

Ningún filósofo, poeta, matemático, científico o astrónomo hace referencia a un objeto así. Además, según los conocimientos actuales sobre la ciencia de la antigua Grecia, no había tradición ni conocimiento capaz de producir tal máquina.

«Historia Moderna»: Calculadora de Schickard

Después, durante más de mil quinientos años, nada. En general, se considera la primera calculadora «real» la que fabricó en 1623 William Schickard. Schickard era amigo del astrónomo Johannes Kepler, que descubrió las leyes de los movimientos planetarios.

Kepler despertó el interés latente por las matemáticas del catedrático de hebreo, cuya habilidad para realizar cálculos se había apolillado un poco con el paso

de los años. Así que decidió fabricar una máquina que lo ayudara con sus sumas. La máquina de Schickard se ha descrito como un «reloj de cálculo». Se pretendía que sirviera de ayuda a los astrónomos, al permitirles calcular las efemérides (las futuras posiciones del Sol, la Luna y los planetas).

Calculadora de Pascal: Ese tipo estaba en todo

Pero volvamos al ordenador digital. El siguiente avance en este campo vino de la mano del matemático francés del siglo XVII, Blaise Pascal, que casualmente nació en 1623, el mismo año en que Schickard había inventado el «reloj de cálculo» original.

Calculadora de Leibniz: Lo que nunca fue

El siguiente avance significativo para el ordenador digital lo logró el filósofo alemán Gottfried Leibniz, el Leonardo da Vinci de su época.

Entre otras muchas cosas, Leibniz creó nada menos que dos filosofías (una optimista y otra pesimista), un plan detallado para la invasión de Egipto, una historia en 15 volúmenes de la Casa de Hannover y una calculadora muy superior a la de Pascal. El interés de Leibniz por las calculadoras no era únicamente práctico.

Una madrezota

En cuanto Leibniz hubo terminado su máquina, cruzó el Canal de la Mancha para mostrarla a la Royal Society de Londres. Sus miembros no parecieron impresionados, y abandonó el proyecto cuando aún no tenía más que un prototipo. A pesar de estas limitaciones, la máquina de Leibniz era extraordinaria. Al igual que la de Pascal, se accionaba mediante una sucesión de ruedas dentadas, pero era capaz de hacer muchas más cosas que la de Pascal. Desde el primer momento podía multiplicar (mediante sumas repetidas), pero además Leibniz pronto añadió unos dispositivos que permitían efectuar divisiones y calcular también raíces cuadradas.

Calculadoras: La solución a Todo

Para él, algún día, las calculadoras resolverían todas las disputas éticas. Bastaría con insertar los diferentes argumentos y la máquina «calcularía» cuál era superior (aunque las bases precisas para semejante cálculo quedaron en la misma categoría que el cálculo de las posibilidades de la inexistencia de Dios: es decir, siguen siendo un misterio para todos, salvo para el genio que las concibió).

Del mismo modo, Leibniz predijo también que las calculadoras quitarían trabajo a los jueces: los tribunales del futuro estarían presididos por calculadoras que emitirían tanto el fallo como la sentencia adecuada.

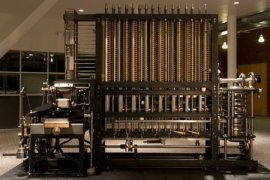

Máquina de Babbage: ¡Papá esta en casa bitches!

En general, se reconoce a Charles Babbage como el padre de las computadoras. Al igual que muchos genios prácticos, era increíblemente poco práctico en cualquier sentido de la palabra, pero sus descubrimientos y logros estaban un siglo por delante de su tiempo.

Babbage decidió que había una única solución para el problema de las tablas astronómicas erróneas. Había que construir una calculadora grande, infalible y multiusos.

Este proyecto era enormemente ambicioso: la máquina de Babbage tenía que ser capaz de calcular cifras de hasta 20 dígitos; también tenía que almacenar una serie de números y efectuar sumas con estos. Los cálculos de la máquina podían reducirse a sumas porque utilizaría el método de las múltiples diferencias

Como sus antecesores, la «máquina diferencial n o 1» utilizaba ruedas dentadas y funcionaba con el sistema decimal, pero su fabricación superaba con mucho la complejidad de las máquinas anteriores, lo que hizo necesarios diversos avances dentro de la ingeniería mecánica.

Después de diez años de trabajo, Babbage había convertido su proyecto original en una máquina de 25 000 piezas (y solo se habían fabricado 12 000), y el coste se elevaba a 17 470 libras (en aquellos días, esa suma era suficiente para fabricar un par de buques de guerra). Babbage había puesto grandes sumas de su propio bolsillo, pero el Gobierno decidió frenar el proyecto.

Era mejor invertir en una flota que en una máquina que podría acabar contribuyendo a la deuda nacional en una cifra que solo esa misma máquina podría calcular.

La «máquina diferencial n o 2» se convirtió en la primera máquina analítica: una máquina cuyo funcionamiento estaba controlado por un programa externo.

Babbage había oído hablar de la idea de Jacquard sobre las tarjetas perforadas para controlar el mecanismo de una máquina y decidió incorporarla a su propia máquina. Esto le permitiría realizar cualquier cálculo aritmético en función de unas instrucciones insertadas en tarjetas perforadas.

Babbage había oído hablar de la idea de Jacquard sobre las tarjetas perforadas para controlar el mecanismo de una máquina y decidió incorporarla a su propia máquina. Esto le permitiría realizar cualquier cálculo aritmético en función de unas instrucciones insertadas en tarjetas perforadas.

Al igual que la primera máquina diferencial, también necesitaba una memoria para almacenar números, pero la nueva máquina debería poder realizar una secuencia de operaciones con esos números almacenados. Babbage había dado con las características esenciales del ordenador moderno.

Babbage había definido las características básicas del ordenador moderno, pero sus máquinas presentaban una desventaja fundamental: funcionaban solo dentro de las matemáticas decimales. Este problema se solucionó gracias al trabajo de George Boole.

Boole: Un lenguaje para dominarlos a todos

En 1854, Boole publicó su Investigation of the Laws of Thought (Investigación de las leyes del pensamiento), que introdujo lo que actualmente se conoce como álgebra booleana.

En esta obra, Boole sugería que la lógica pertenece al ámbito de las matemáticas, más que al de la filosofía. Al igual que la geometría, se basa en una serie de axiomas sencillos. Además, al igual que la aritmética tiene unas funciones primarias, como la suma, la multiplicación y la división, la lógica puede reducirse a operadores como:

- AND

- OR

- NOT

Estos operadores pueden utilizarse en un sistema binario (el sistema digital tiene diez dígitos; el sistema binario funciona igual, pero solo con dos). El «verdadero» y «falso» de la lógica se reducen al 0 y 1 de la matemática binaria.

Boss

Así, el álgebra binaria reduce cualquier proposición lógica, independientemente del número de términos que contenga, a una simple secuencia de símbolos binarios. Eso cabría en una simple tira de papel, en la que el álgebra binaria se reduce a una secuencia de orificios (y ausencia de orificios). De este modo, se podría introducir todo un «argumento» lógico o programa en una máquina.

Con dígitos binarios, las máquinas podrían seguir instrucciones lógicas y su matemática se adaptaba perfectamente al circuito eléctrico de encendido/apagado. Así, el dígito binario (o bit) llegó a ser la unidad fundamental de información de los sistemas informáticos.

Herman Hollerith: Money, money!

En lo que al mundo respecta, el siguiente paso importante lo dio Herman Hollerith, un estadístico estadounidense. Hollerith desarrolló una «máquina de censo», que podía leer tarjetas de hasta 288 orificios, y almacenar la información. Su máquina electromecánica podía leer hasta 80 tarjetas por minuto.

En lo que al mundo respecta, el siguiente paso importante lo dio Herman Hollerith, un estadístico estadounidense. Hollerith desarrolló una «máquina de censo», que podía leer tarjetas de hasta 288 orificios, y almacenar la información. Su máquina electromecánica podía leer hasta 80 tarjetas por minuto.

Cuando se utilizó para el censo de estadounidenses de 1890, la máquina de Hollerith procesó todos los datos en seis semanas (la elaboración del anterior censo, de 1880, había llevado tres años). En 1896 Hollerith se metió en el mundo de los negocios, y creó la Tabulating Machine Company, que más adelante se convertiría en la International Business Machine Corporation (IBM).

¿Y ahora que hacemos con esto?

Se habían descubierto los elementos necesarios para el ordenador moderno (incluyendo la explotación comercial). Lo único que faltaba era que alguien descubriera qué podía hacer: las posibilidades y limitaciones teóricas. Esto fue lo que hizo Alan Turing.

Alan Turing

Estúpido y sensual Turing

Alan Turing es el hombre que debemos agradecer por un mundo libre de Nazis y lleno de computadoras.

…Y lo feo es que no tienes ni idea de lo mal que lo tratamos.

En 1936, Alan Turing publicó un artículo titulado «Computables Numbers, with a Application to the Entscheidungs problem», en el que presentaba la noción de una máquina universal (más tarde llamada «máquina universal de Turing» y luego «máquina de Turing») capaz de computar cualquier cosa que sea computable. El concepto central de la computadora moderna se basó en el papel de Turing.

Propuesta de una máquina de Turing

Deja que te lo explique de otra manera, el en su cabeza pensó en una máquina que pudiera calcular todo aquello que fuera calculable… sin crearla…Antes siquiera de que existiera la primera computadora moderna. ESO ES SER UN GENIO.

Durante los próximos dos años, Turing estudió matemáticas y criptología en el Instituto de Estudios Avanzados de Princeton.

Después de recibir su Doctorado volvió a Cambridge, y entonces tomó una posición a tiempo parcial con el código del gobierno y la escuela del Cypher, una organización británica que descifraba códigos.

Durante la Segunda Guerra Mundial, Turing fue un participante destacado en el Código Enigma. Las contribuciones de Turing al proceso de codificación no se detuvieron allí: también escribió dos artículos sobre métodos matemáticos para descifrar más códigos.

Durante la Segunda Guerra Mundial, Turing fue un participante destacado en el Código Enigma. Las contribuciones de Turing al proceso de codificación no se detuvieron allí: también escribió dos artículos sobre métodos matemáticos para descifrar más códigos.

Turing se trasladó a Londres a mediados de la década de 1940 y comenzó a trabajar para el National Physical Laboratory. Entre sus contribuciones más notables mientras trabajaba en la instalación, Turing lideró el trabajo de diseño para el Mecanismo Automático de Computación.

Aunque una versión completa de la ACE nunca fue construida, su concepto ha sido utilizado como un modelo por las corporaciones de tecnología en todo el mundo durante varios años, influyendo en el diseño del DEUCE y el Bendix G-15-acreditado por muchos como la primera computadora personal del mundo.

Abordó el tema de la inteligencia artificial en su artículo de 1950, «Computación de maquinaria e inteligencia», y propuso un experimento conocido como «Prueba de Turing», un esfuerzo para crear un estándar de diseño de inteligencia para la industria tecnológica.

Von Neumann

Nació Budapest (Hungría) en 1903, es my famosa la historia de que desde que era pequeño tenía una memoria fotográfica, era capaz de memorizar y recitar una página de una guía de teléfonos en pocos minutos.

Publicó su primer trabajo matemático en colaboración con su maestro los 18 años y decidió estudiar matemáticas en la Universidad de Budapest en 1921 y durante los años siguientes asistió a la Universidad de Berlín y al Instituto Federal Suizo de Tecnología en Zurich. En 1926, recibió su Doctorado en matemáticas.

Von Neumann se describe comúnmente como un bromista y siempre se la vivía de fiesta. Lo cual contrasta mucho con la idea que siempre tenemos de los científicos y los computologos, retraídos y muy tímidos. Von Neumann era como el R. Feynman de la computación.

Foto 100% Real no Fake

A pesar de sus peculiaridades de personalidad, nadie podía negar que Von Neumann era brillante. A partir de 1927, Von Neumann aplicó nuevos métodos matemáticos a la teoría cuántica. Su trabajo fue instrumental en las posteriores interpretaciones «filosóficas» de la teoría.

Además es uno de los grandes padres de las teoría del juego en especial gracias a su libro «Theory of Games and Economic Behavior».

Era tan seguro de sus teorías que desde el comienzo de la Segunda Guerra Mundial confiaba en la victoria de los Aliados, es más esbozó un modelo matemático del conflicto del que dedujo que los Aliados ganarían, aplicando algunos de los métodos de la teoría que el mismo había desarrollado. Incluso trabajo en el Proyecto Manhattan.

¿Y las computadoras?

«De todo el trabajo de posguerra de Von Neumann, su desarrollo de la computadora digital es el que causó mas impacto al día de hoy.» (Poundstone página 76) .

Después de examinar el ENIAC del ejército durante la guerra, Von Neumann se volvió casi loco porque estaba lleno de ideas para diseñar una computadora mejor, usando sus habilidades matemáticas para mejorar el diseño lógico de la computadora.

Aquí pasando el rato – Von «Pillin» Neumann

Una vez que la guerra había terminado, la Marina de Estados Unidos proporcionó fondos para la máquina de Von Neumann, que él afirmó sería capaz de predecir con precisión los patrones climáticos.

Capaz de 2.000 operaciones por segundo, la computadora no predijo el tiempo muy bien (XD) , pero se hizo bastante útil haciendo un conjunto de cálculos necesarios para el diseño de la bomba de hidrógeno.

Cita también real

Von Neumann también es acreditado con la idea de basar los cálculos de la computadora en números binarios, teniendo programas almacenados en la memoria del ordenador en forma codificada en contraposición a tiras de papel (que quizá recuerdes), y varios otros desarrollos cruciales. La esposa de Von Neumann, Klara, se convirtió en uno de las primeros programadoras.

Von Neumann más tarde ayudó a diseñar el sistema informático SAGE diseñado para detectar un ataque nuclear soviético

John Hopcroft

Siempre es común hablar de el junto con su colega Jeffrey D. Ullman a través de la investigación pionera y libros de texto de gran alcance, John Hopcroft y Jeffrey D. Ullman son conocidos como dos de las figuras más influyentes responsables de dar forma al campo de la informática.

Ese men

Estos gigantes de la informática se conocieron por primera vez en 1964 cuando el Dr. Ullman tomó el curso de teoría de autómatas del Dr. Hopcroft en la Universidad de Princeton.

Juntos, escribieron el libro sobre la teoría de autómatas y lenguajes formales que fue utilizado por las universidades de todo el mundo para educar a la primera generación de informáticos, las lenguas formales y su relación con los autómatas, su sucesor, Teoría de los Autómatas, Lenguajes y Computación, todavía está en uso hoy en día.

El Dr. Hopcroft es considerado uno de solamente un puñado de los informáticos que crearon la disciplina de la informática teórica, unificando la teoría de los autómatas y lenguajes formales durante los últimos años 60.

También determinó que la programación de computadoras podría ser sintetizada en una teoría de algoritmos y que estos algoritmos podrían ser evaluados por su complejidad asintótica. Esto condujo a un conjunto de principios de diseño que podrían utilizarse para diseñar algoritmos óptimos. Un compañero de la vida de IEEE, el Dr. Hopcroft es también un miembro de la Academia Nacional de las Ciencias y de la Academia Nacional de la Ingeniería.

Actualmente es el Profesor de Ingeniería y Matemáticas Aplicadas de IBM en la Universidad de Cornell, Ithaca, N.Y.

Dennis Ritchie

El es uno de los padres de la computación actual, si hoy en día tenemos celulares en nuestras casas, ordenadores, o demás es porque el motivado el gran boom! del software.

Mi humilde traducción a este:

Precioso meme

El al crear C, que es lo que ha hecho crecer al mundo de los ordenadores, hablando de fechas, el creo C en 1972 mientras trabajaba para Bell Labs junto con Kerrigan todo el equipo estaba trabajando en el desarrollo de un nuevo sistema operativo….UNIX. C fue creado con un solo propósito: CREAR Y TRABAJAR en UNIX.

Generaciones de las Computadoras

Una forma común de entender a las computadoras es entenderlas por generaciones, he de aclarar antes de empezar que esto es un desorden (como la historia en general) ¿Qué es la historia moderna?¿ En que día empezó el imperialismo?

Esta categoría no tiene las líneas o límites claro, y no busca eso, sino más bien busca darte una idea de la evolución de estas maquinas.

Primera Generación (1942-1958)

ENIAC

En esta generación había una gran desconocimiento de las capacidades de las computadoras, puesto que se realizó un estudio en esta época que determinó que con veinte computadoras se saturaría el mercado de los Estados Unidos en el campo de procesamiento de datos.

Características:

- Usaban tubos al vacío para procesar información.

- Usaban cilindros magnéticos para almacenar información e instrucciones internas.

- Eran sumamente grandes, utilizaban gran cantidad de electricidad, generaban gran cantidad de calor y eran sumamente lentas.

- Se comenzó a utilizar el sistema binario para representar los datos.

- En esta generación las máquinas son grandes y costosas (de un costo aproximado de 10,000 dólares).

La computadora más exitosa de la primera generación fue la IBM 650, de la cual se produjeron varios cientos. Esta computadora que usaba un esquema de memoria secundaria llamado tambor magnético, que es el antecesor de los discos actuales.

También podemos destacar de gran manera a al ENIAC (Electronic Numeric Integrator And Calculator).

ENIAC

Acrónimo para «Electronic Numerical Integrator And Calculator», El ENIAC fue la primera computadora electrónica (aunque no usaba aun transistores ni chips integrados) utilizado para fines generales, como resolver problemas numéricos.

Fue inventado en la Universidad de Pensilvania en un esfuerzo para cálculos de artillería para el Laboratorio de Investigación Balística del Ejército de los Estados Unidos.

Su construcción comenzó en 1943. El ENIAC utilizó 17.468 tubos de vacío, 15.000 releays y pesó casi 50 toneladas, utiliza 200,000 Volts y costó alrededor de $ 500,000.

Aunque no fue terminado hasta el final de la Segunda Guerra Mundial, el ENIAC fue creado para ayudar con el esfuerzo de la guerra contra las fuerzas alemanas. (Eso se llama llegar muy tarde).

Lo que distinguía a ENIAC de los demás era que una máquina de trabajo que realizaba miles de cálculos por segundo y sobretodo que podía ser reprogramada fácilmente para diferentes tareas. Fue un impresionante.

El 14 de febrero de 1946, el gobierno dio a conocer a ENIAC al dejarla de hacer un secreto, fue dado a conocer con frases como: «Una nueva máquina que se espera que revolucione las matemáticas y la ingeniería y cambie muchos de nuestros métodos de diseño industrial». Los primeros comunicados describían a un «robot matemático» que trabajaba a una velocidad «fenomenal» que «libera el pensamiento a los científicos , ya que evitaba la pesadez de un largo trabajo de puros cálculos».

El ENIAC se exhibe ahora en la Institución Smithsonian en Washington D.C.

Segunda Generación (1958-1964)

Transistores. Eso lo cambio TODO.

En esta generación las computadoras se reducen de tamaño y son de menor costo. Aparecen muchas compañías y las computadoras eran bastante avanzadas para su época. Algunas computadoras se programaban con cinta perforadas y otras por medio de cableado en un tablero.

Características:

- Usaban transistores para procesar información. Los transistores eran más rápidos, pequeños y más confiables que los tubos al vacío.

200 transistores podían acomodarse en la misma cantidad de espacio que un tubo al vacío. - Usaban pequeños anillos magnéticos para almacenar información e instrucciones. cantidad de calor y eran sumamente lentas.

- Se mejoraron los programas de computadoras que fueron desarrollados durante la primera generación. Usaban ahora algo conocido como Ensamblador,además se desarrollaron nuevos lenguajes de programación como COBOL y FORTRAN, los cuales eran comercialmente accesibles.

- Se comenzó a disminuir el tamaño de las computadoras.

Tercera Generación (1964-1971)

La tercera generación de computadoras emergió con el desarrollo de circuitos integrados (pastillas de silicio) en las que se colocan miles de componentes electrónicos en una integración en miniatura.

Las computadoras nuevamente se hicieron más pequeñas, más rápidas, desprendían menos calor y eran energéticamente más eficientes. El ordenador IBM-360 dominó las ventas de la tercera generación de ordenadores desde su presentación en 1965. El PDP-8 de la Digital Equipment Corporation fue el primer miniordenador.

Características:

- Se desarrollaron circuitos integrados para procesar información.

- Se desarrollaron los «chips» para almacenar y procesar la información. Un «chip» es una pieza de silicio que contiene los componentes electrónicos en miniatura llamados semiconductores.

- Los circuitos integrados recuerdan los datos, ya que almacenan la información como cargas eléctricas.

- Surge la multiprogramación.

- Emerge la industria del «software«.

- Otra vez las computadoras se tornan más pequeñas, más ligeras y más eficientes.

- Consumían menos electricidad, por lo tanto, generaban menos calor.

Cuarta Generación (1971-?)

Aparecen los microprocesadores que es un gran adelanto de la microelectrónica, son circuitos integrados de alta densidad y con una velocidad impresionante. Las micro computadoras con base en estos circuitos son extremadamente pequeñas y baratas, por lo que su uso se extiende al mercado industrial y comercial.

Aquí nacen las computadoras personales que han adquirido proporciones enormes y que han influido en la sociedad en general sobre la llamada «revolución informática».

Características:

- Se desarrolló el microprocesador.

- Se colocan más circuitos dentro de un «chip».

«LSI – Large Scale Integration circuit».

«VLSI – Very Large Scale Integration circuit». - Cada «chip» puede hacer diferentes tareas.

- Un «chip» sencillo actualmente contiene la unidad de control y la unidad de aritmética/lógica. El tercer componente, la memoria primaria, es operado por otros «chips».

- Se reemplaza la memoria de anillos magnéticos por la memoria de «chips» de silicio.

- Se desarrollan las microcomputadoras, o sea, computadoras personales o PC.

- Se desarrollan las supercomputadoras.

¿Quinta Generación?

Hasta aquí parece que todo mas o menos un acuerdo común pero… ¿Es un computadora de 1971 de la misma generación que una MacBook de 2016? Pues yo..YO diría que sí, que correr bajo una misma arquitectura y que en esencia son lo mismo, pero veamos otras posturas.

En vista de la acelerada marcha de la microelectrónica, la sociedad industrial se ha dado a la tarea de poner también a esa altura el desarrollo del software y los sistemas con que se manejan las computadoras.

Surge la competencia internacional por el dominio del mercado de la computación, en la que se perfilan dos líderes que, sin embargo, no han podido alcanzar el nivel que se desea: la capacidad de comunicarse con la computadora en un lenguaje más cotidiano y no a través de códigos o lenguajes de control especializados.

Japón lanzó en 1983 el llamado «programa de la quinta generación de computadoras», con los objetivos explícitos de producir máquinas con innovaciones reales en los criterios mencionados. Y en los Estados Unidos ya está en actividad un programa en desarrollo que persigue objetivos semejantes, que pueden resumirse de la siguiente manera:

- Se desarrollan las micro computadoras, o sea, computadoras personales o PC.

- Se desarrollan las supercomputadoras.

|

|

|

|